Leyes matemáticas en el uso del lenguaje

La cuidadosa y precisa elección de las palabras por parte del escritor es un ingrediente básico de la buena literatura. Cada autor posee la libertad de elegir qué palabra usar en cada instante de un libro; sin embargo, hace un siglo se empezó a vislumbrar que el autor no es libre de elegir en qué proporción aparece en su propia obra cada palabra respecto a las demás. Es la ley de Zipf (lingüista americano fallecido en 1950) la que dicta la frecuencia de aparición de cada palabra para una obra dada, sin importar el autor, el idioma, la calidad literaria, ni incluso si se trata de literatura o de un manual de jardinería.

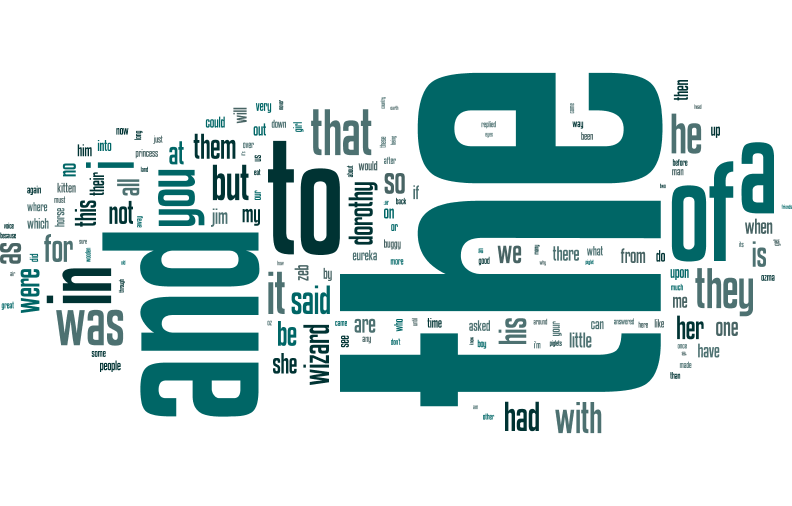

Así, la palabra más común en un texto aparecerá aproximadamente el doble de veces que la segunda más común, y el triple que la tercera más usada, y así sucesivamente. Por ejemplo, en Dorothy and the Wizard of Oz, de L. Frank Baum, la palabra más frecuente es "the", con 3137 apariciones en todo el texto, la segunda más común, "and", aparece 1544 veces, la tercera, "to", 1107, y así hasta palabras como "wizardries" que aparecen sólo una vez. Una curiosa consecuencia de esta ley es que no existe ninguna diferencia fundamental entre palabras comunes y palabras raras; la distinción es totalmente arbitraria; además, textos cada vez más largos nunca dejarían de sorprendernos con palabras nuevas. Dada su importancia al describir el vocabulario de los autores, la ley de Zipf constituye el resultado primordial de la disciplina llamada lingüística cuantitativa.

Aún más intrigantemente, la ley de Zipf va más allá de la lingüística, encontrando una gran aplicabilidad en las ciencias humanas, en la tecnología, o en la biología. Podemos considerar la demografía de Estados Unidos, donde la ciudad más poblada, Nueva York, tiene (aproximadamente) el doble de habitantes que Los Ángeles, el triple que Chicago, etc. Lo mismo pasa con el número de empleados de las empresas, el número de fieles de las diferentes religiones y sectas, el número de enlaces o visitas que recibe cada página en Internet, o el número de copias con que cuenta cada proteína dentro de una célula.

Sin embargo, a pesar de su aparente ubicuidad, la ley de Zipf adolece de dos grandes defectos. Primero, su carácter parece más cualitativo que cuantitativo: ¿qué quiere decir que la palabra más común aparecerá “aproximadamente” el doble de veces que la siguiente más común? ¿Hasta dónde se puede estirar la aproximación? Y segundo, en el caso de la lingüística, la ley no ha sido confrontada con un número realmente grande de textos, con lo cual, su apoyo empírico no pasaría de ser anecdótico.

Patrocinados por la Fundación La Caixa, hemos tratado de dar un contenido estadístico-matemático preciso a la ley de Zipf, y de situarla en la nueva era del “Big Data”. Así pues, empezamos descargando todos los libros en inglés (más de 30.000) existentes en la web del Proyecto Gutenberg (un importante repositorio de libros electrónicos gratuitos). Después, tuvimos que encontrar una representación más clara desde el punto de vista probabilista de esta ley, que no asociara probabilidades con palabras sino probabilidades con variables numéricas. La solución ya era conocida por el propio Zipf: si, una vez se han contado el número de apariciones de cada palabra en un texto, se decide hacer una segunda estadística, contando cuántas palabras (diferentes) aparecen un número dado de veces, se obtiene una ley equivalente a la de Zipf: el número de palabras que sólo aparecen una vez en el texto es el cuádruplo (22) del número de palabras que aparecen dos veces, y el nónuplo (32) del número de palabras que aparecen tres veces, y así sucesivamente. También resulta conveniente añadir un parámetro libre a la ley, para dotarla de más flexibilidad, de tal manera que el número de palabras que aparecen una vez sea un factor 22δ de las que aparecen dos veces, 32δ de las que aparecen 3 veces, etc., esperando que el parámetro δ tome valores cercanos a uno.

Aunque es común en la bibliografía considerar las dos representaciones mencionadas de la ley de Zipf como equivalentes, un tratamiento matemático riguroso muestra que la equivalencia se daría si la frecuencia de las palabras fuera una variable continua, pero está claro que la variable sólo toma valores discretos (enteros). Inmediatamente se puede ver que la ley de Zipf presenta una ambigüedad en su definición, dependiendo de qué representación se escoja para ella. Ante esta ambigüedad, la mejor opción es dejar hablar a los datos, y que sean éstos los que escojan la forma óptima de la ley de Zipf. Aplicando técnicas estadísticas bien conocidas, como la estimación por máxima verosimilitud (o mínima inverosimilitud, como preferimos llamarla) y los tests de bondad de ajuste, se pueden comparar las diferentes opciones de manera cuantitativa.

Una versión un tanto sofisticada matemáticamente de la ley de Zipf (deducida por Benoit Mandelbrot, el padre de los fractales, en los años 60) funciona realmente mal, siendo rechazada en más del 99 % de los libros (con un nivel de confianza del 95 %). Sin embargo, otra versión más simple da cuenta del 40 % de los textos (el ajuste es aceptable, o no se puede rechazar, con un 95 % de confianza). Encontramos muy remarcable que una ley tan simple, con un sólo parámetro, pueda describir un número tan grande de libros (la famosa campana de Gauss, aplicable en situaciones totalmente diferentes, necesita siempre dos parámetros: la posición de la campana y su anchura). Además, los tests estadísticos son particularmente estrictos para las palabras menos comunes; si la proporción entre el número de palabras que salen una vez y que salen dos veces se desvía ligeramente de lo predicho por la ley, el ajuste es rechazado. Por tanto, modelizando aparte el número de palabras que salen una vez, o dos, etc., el rango de aplicabilidad de esta versión de la ley de Zipf se incrementa drásticamente.

Nuestros resultados son válidos para textos en inglés (la lengua avasalladoramente más presente en Internet, y en particular en el Proyecto Gutenberg). Es posible que para la lengua castellana las conclusiones fueran diferentes, pues las sutilezas de la ley de Zipf se presentan para las palabras menos comunes (donde dejan de valer las aproximaciones continuas y los efectos discretos salen a la luz). Y es que la riqueza morfológica del castellano (en comparación con el inglés) incrementa sustancialmente el número de estas palabras. Desgraciadamente, son pocas aún las obras electrónicas en castellano accesibles fácilmente.

No podemos concluir sin preguntarnos sobre el origen de esta misteriosa ley. En realidad, la pregunta se ha intentado contestar desde hace más de medio siglo, sin una respuesta clara, y con un encendido debate. En los años 50, el psicólogo George Miller criticó la relevancia desde el punto de vista cognitivo de la ley de Zipf, al poder ser aparentemente explicada por la acción de un mono golpeando aleatoriamente teclas en una máquina de escribir. Pero está claro que el lenguaje humano no procede de este modo. En la misma época, el luego Premio Nobel de Economía Herbert Simon puso el origen de la ley en el mismo efecto por el que los ricos se hacen más ricos (el dinero llama al dinero): cuanto más aparece una palabra a lo largo de un texto, su "tasa de crecimiento" se hace más alta. Quizás este modelo pueda explicar, cualitativamente, el desarrollo de las ciudades o las empresas, pero su aplicabilidad al lenguaje es cuestionable. Otras explicaciones basadas en la teoría de la información también han sido criticadas, así que a falta de modelos comúnmente aceptados, nos tenemos que conformar de momento con los incontrovertibles hechos empíricos.

Artículo Álvaro Corral, Isabel Moreno-Sánchez y Francesc Font-Clos (Artículo publicado en Investigación y Ciencia, 2016)

PARA SABER MÁS

Confronting the Mistery of Urban Hierarchy. P. Krugman en Journal of the Japanese and International Economies, vol. 10, págs 399-418, 1996.

Power laws, Pareto distributions and Zipf’s law. M. E. J. Newman en Contemporary Physics, vol. 46, págs. 323–351, 2005.

Large-Scale Analysis of Zipf’s Law in English Texts. I. Moreno-Sánchez, F. Font-Clos, A. Corral en PLoS ONE, vol. 11, e0147073, 2016.